En informatique, l’octet est une unité de mesure correspondant à 8 bits de données, permettant d’écrire jusqu’à 256 valeurs différentes avec l’emploi du système binaire (0 et 1) pour chaque bit. Par ailleurs, grâce à l’emploi de systèmes de codages normalisés (comme le codage ASCII par exemple), il est possible d’associer chaque valeur à un caractère pour transmettre de l’information textuelle. De quoi permettre dans un octet d’écrire l’intégralité de l’alphabet latin (y compris les accents), des chiffres, et de la ponctuation (y compris les espaces) et des caractères spéciaux.

Standardisation de l’octet dans l’industrie informatique

L’existence de l’octet provient du fait que les processeurs des ordinateurs n’opèrent pas d’opérations sur des bits individuels, mais sur des groupes de bits dont le nombre peut varier. Toutefois, dans un souci d’harmonisation, tous les fabricants de matériels informatiques ont pris l’habitude de produire des appareils qui traitent exclusivement les bits de données par groupe de huit. Ce qui a conduit l’octet à devenir une unité de mesure à part entière.

Utilisation de l’octet pour mesurer la capacité et la vitesse de transfert

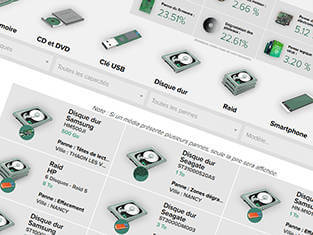

L’octet est principalement utilisé pour indiquer la capacité d’une mémoire (mémoire vive ou mémoire de masse) d’une machine ou l’espace de stockage d’un support (disque dur, disque SSD, clé USB). Ceci dit, vu les performances très élevées des technologies modernes, on se sert davantage des multiples de l’octet comme le mégaoctet (1 million d’octets), le gigaoctet (1 milliard d’octets) ou encore le téraoctet (1 000 milliards d’octets). L’octet peut aussi servir à mesurer une vitesse de transfert de données, qui est alors établie par un nombre d’octets (ou un de ses multiples) par seconde.